นักวิจัยสร้างระบบ AI เพื่อต่อกรกับข่าวปลอมที่ถูกเขียนขึ้นโดย AI ด้วยกันเอง

Korn-Kung

Korn-Kungโลกโซเชียลมีเดียทุกวันนี้มีข่าวปลอมถูกเขียนขึ้นมามากมาย ทั้งบน Facebook และ Twitter ความน่ากลัวของข่าวปลอมคือมันแพร่กระจายได้ไวมาก ซึ่งข่าวปลอมส่วนมากถูกเขียนขึ้นโดยฝีมือมนุษย์ แต่ก็มีบางส่วนที่ถูกเขียนขึ้นโดย AI และมีแนวโน้มในอนาคต AI จะสามารถเขียนข่าวปลอมได้แนบเนียนมากขึ้น จนมนุษย์แทบจะแยกไม่ออกได้ว่าอันไหนมาจากฝีมือ AI หรือฝีมือมนุษย์ด้วยกันเอง ยกตัวอย่างเช่น โมเดล AI ที่ชื่อ GPT–2 จาก OpenAI มันฉลาดจนเขียนข่าวปลอมที่อ่านแล้วยังคิดว่าเป็นข่าวจริง เป็นต้น ถ้าถึงตอนที่สายตามนุษย์แยกไม่ออกแล้วจะเป็นอย่างไร?

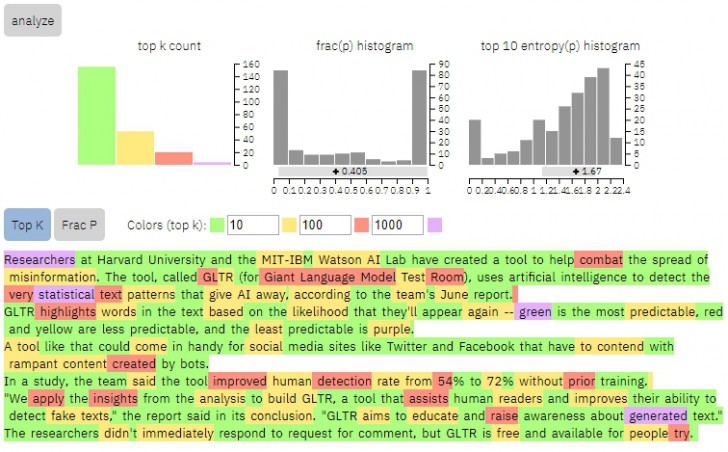

เพื่อเตรียมตัวตั้งแต่เนิ่นๆ นักวิจัยจากมหาวิทยาลัย Harvard และศูนย์วิจัย MIT-IBM Watson AI Lab จึงได้ร่วมกันสร้างระบบสมองกล AI ที่สามารถต่อกรกับข่าวปลอมที่ถูกเขียนโดย AI ด้วยกันเองได้" โดยอาศัยการตรวจจับคำศัพท์และนำมาวิเคราะห์

- OpenAI ยืนยันเอง ต่อไปนี้ผู้ใช้งาน ChatGPT จะพบกับโฆษณาบนแอป

- แฮกเกอร์อาศัย AI Agent "Skill" ของ OpenClaw ส่งมัลแวร์ลงระบบของเหยื่อ

- Thaiware Live Talk EP.3 : งานก็เยอะ คนก็แยะ Canva ช่วยด้วย !!

- Thaiware จัดงาน “Sawasdee Canva” ประกาศความเป็นตัวแทนจำหน่าย Canva สำหรับธุรกิจรายแรกในไทย

- แอปความปลอดภัยไซเบอร์ปลอม ใช้แหล่งฝากแอป AI "Hugging Face" ปล่อยมัลแวร์ลง Android

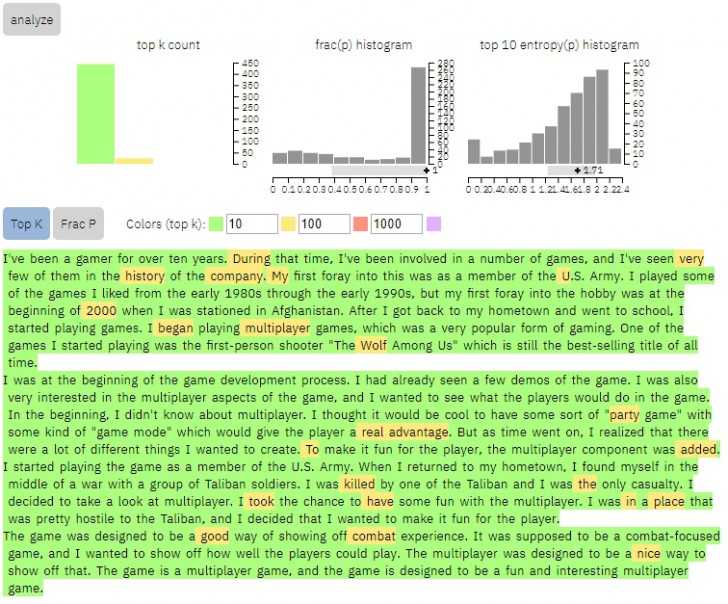

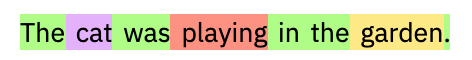

โดยระบบ AI นี้ ถูกเรียกว่า GLTR (Giant Language Model Test Room) มันถูกสร้างขึ้นมาโดยเฉพาะ เพื่อใช้ตรวจจับรูปแบบการเขียนและใช้คำศัพท์ในบทความ (Text Patterns) แล้วนำไปวิเคราะห์พร้อมกับเก็บสถิติที่ตรวจพบ และแสดงผลออกมาให้เห็นในรูปแบบการไฮไลท์คำศัพท์

การไฮไลท์คำศัพท์จะแบ่งออกเป็น 3 ระดับคือ ไฮไลท์สีเขียวเป็นคำศัพท์ที่พบบ่อย ,สีเหลืองและสีแดงพบได้ปานกลางและน้อย สุดท้ายสีม่วงเป็นคำที่พบน้อยมาก

การตรวจจับข่าวปลอมว่าถูกเขียนขึ้นโดย AI หรือไม่ ทำได้ด้วยการดูผลลัพธ์ โดยบทความที่ AI เขียนขึ้น เนื้อหาในบทความอาจจะมีความไม่เชื่อมโยงกัน (เป็นกลุ่มเป็นก้อน) และมีไฮไลท์สีเขียวและเหลืองเป็นส่วนใหญ่ (เพราะ AI มักเลือกใช้คำที่พบเจอบ่อยที่สุด จึงเดาได้ง่าย) กลับกันบทความที่มนุษย์เขียนขึ้น จะมีความซับซ้อนกว่า ทำให้มีการสลับสีระหว่างสีแดงและสีม่วงมากกว่า

ถ้าหากว่าเอา GLTR มาใช้ในการตรวจข่าวปลอมบน Facebook หรือ Twitter น่าจะเวิร์คพอสมควร เพราะว่ามันสามารถทำให้มนุษย์เห็นรูปการเลือกใช้คำได้อย่างชัดเจนว่าเป็นมนุษย์หรือ AI แต่ถึงอย่างนั้น GLTR ก็ยังไม่สามารถตรวจจับได้แบบ 100% ยังต้องอาศัยการตัดสินใจจากมนุษย์อีกที

โดยตัว GLTR ที่ว่านี้ทางนักวิจัยเปิดให้เข้าไปใช้ฟรีด้วย ที่เว็บไซต์นี้เลย https://gltr.io/dist/index.html

ที่มา : www.cnet.com , www.avanade.com

คำสำคัญ »

คำสำคัญ »

|

|

How to .... |

ข่าวไอทีที่เกี่ยวข้อง

ซอฟต์แวร์

ซอฟต์แวร์ แอปพลิเคชันบนมือถือ

แอปพลิเคชันบนมือถือ เช็คความเร็วเน็ต (Speedtest)

เช็คความเร็วเน็ต (Speedtest) เช็คไอพี (Check IP)

เช็คไอพี (Check IP) เช็คเลขพัสดุ

เช็คเลขพัสดุ สุ่มออนไลน์

สุ่มออนไลน์