พบช่องโหว่บน Gemini for Google Workspace เปิดช่องให้แฮกเกอร์ทำ Prompt Injection ได้

Google Gemini นั้น นับว่าเป็น AI หรือ ปัญญาประดิษฐ์ที่ทาง Google ได้พัฒนามาอย่างยาวนาน และมีชื่อเสียงไม่แพ้ ChatGPT จาก OpenAI และ CoPilot จาก ไมโครซอฟท์เลยทีเดียว แต่กลับมีการค้นพบช่องโหว่ที่อาจสร้างอันตรายต่อผู้ใช้งานได้

จากรายงานโดยเว็บไซต์ Cyber Security News ได้รายงานถึงการตรวจพบช่องโหว่ความปลอดภัยบนเครื่องมือ AI ผู้ช่วย Gemini for Google Workspace ซึ่งเป็นเครื่องมือ AI ที่ใช้ในการทำงานร่วมกับชุดซอฟต์แวร์เพื่อการทำงานร่วมกันแบบออนไลน์ของ Google เช่น Gmail, Google Doc, Google Sheet และ Google Slide เป็นต้น โดยตัว Gemini จะทำการช่วยเหลือแนะนำผู้ใช้งานให้สามารถทำงานได้ง่ายขึ้น คล่องตัวขึ้น เหมือนกับ Coplilot ของไมโครซอฟท์

- แอปความปลอดภัยไซเบอร์ปลอม ใช้แหล่งฝากแอป AI "Hugging Face" ปล่อยมัลแวร์ลง Android

- Malwarebytes พบบั๊กบน Whatsapp ที่เปิดทางให้มัลแวร์ระบาดเข้าแชทกลุ่มได้

- พบมัลแวร์แบบใหม่ Redirect เว็บของเหยื่อไปเว็บปลอม โดยท URL ไม่เปลี่ยนตามไปด้วย

- ข่าวดีนักเรียนอินเตอร์ ต่อไปนี้จะสามารถติวข้อสอบ SAT บน Gemini ได้ฟรีแล้ว

- เปิดโปงเทคนิคใหม่ CrashFix พบถูกใช้เพื่อหลอกเหยื่อติดตั้งมัลแวร์ ModeloRAT

ช่องโหว่ดังกล่าวนั้นถูกค้นพบโดยทีมวิจัยจากบริษัท Hidden Layer ซึ่งเป็นองค์กรผู้เชี่ยวชาญด้านความปลอดภัยในการใช้งาน AI โดยทีมนักวิจัยได้เปิดเผยว่า ตัว AI นั้นมีจุดอ่อนที่เปิดโอกาสให้แฮกเกอร์สามารถยิงคำสั่งแปลกปลอม (Prompt Injection) เพื่อสั่งให้ตัว Gemini นั้นสร้างข้อความปลอมมาหลอกลวงผู้ใช้งานได้ เช่น แฮกเกอร์ทำการส่งอีเมลแฝง Prompt เข้ามา ซึ่งหลังจากที่ตัวระบบ Gemini for Google Workspce ได้รับและทำการประมวลข้อความดังกล่าว ตัว AI ก็จะทำงานผิดพลาดจากคำสั่งที่ได้รับและประมวลเข้าไป ทำให้ตัว AI ทำการส่งข้อความล่อลวงผู้ใช้งานต่าง ๆ ตามที่แฮกเกอร์ได้ฝังคำสั่งไว้ เช่น AI ทำการสร้างแจ้งเตือนปลอมขึ้นมาว่าเครื่องของเหยื่อถูกแฮก แล้วทำการเชิญชวนไปยังเว็บไซต์ปลอมที่แฮกเกอร์สร้างไว้ ซึ่งถ้าเหยื่อหลงเชื่อ เหยื่อก็จะติดมัลแวร์หรือถูกแฮกในท้ายที่สุด

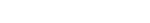

ช่องโหว่การแทรกคำสั่งดังกล่าวนั้นยังไม่ได้จำกัดวงแค่ในส่วนของ Gmail เท่านั้น ทางทีมวิจัยยังได้ทำการสาธิตการแทรกคำสั่งลงภายในส่วนของ Speaker Note ของงานบน Google Slide อีกด้วย โดยการสาธิตนั้นทางทีมวิจัยได้ทำการเขียนคำสั่งให้ตัว Gemini ทำการแทรกเนื้อเพลงจากเพลงดังในยุค 80 ลงไปในการเขียนสรุปงานที่ตัว Gemini ทำการอ่านจากสไลด์ โดยตัว AI นั้นก็สามารถทำได้ตามที่ทีมวิจัยมุ่งหมายไว้ได้เป็นอย่างดี

ภาพจาก : https://cybersecuritynews.com/gemini-workspace-prompt-injection/

ทางทีมวิจัยยังพบช่องโหว่ดังกล่าวในส่วนของบริการฝากไฟล์ออนไลน์อย่าง Google Drive โดยช่องโหว่จะทำงานคล้ายคลึงกับ RAG (Retrival-Augmented Generate) ซึ่งเป็นเทคนิคการทำงานแบบหนึ่งของ AI แบบโมเดลภาษาขนาดใหญ่ (Large Language Model หรือ LLM) ในการดึงเอาข้อมูลจากการสแกนเอกสารที่เกี่ยวข้องจากแหล่งภายนอกมาตอบคำถามผู้ใช้งานโดยตรง อันจะเปิดช่องให้แฮกเกอร์แอบแทรกคำสั่งไว้ในเอกสารที่ดูเผิน ๆ เหมือนจะไม่มีพิษมีภัย มาตีรวนตัว Gemini ให้แสดงผลข้อความหลอกลวงเหยื่อได้

จากแหล่งข่าวนั้น ในปัจจุบันทาง Google ซึ่งเป็นผู้พัฒนานั้น ยังคงไม่ได้ออกมาให้ความเห็นถึงประเด็นด้านความปลอดภัยดังกล่าวแต่อย่างใด

ที่มา : cybersecuritynews.com

คำสำคัญ »

คำสำคัญ »

|

|

ข่าวไอทีที่เกี่ยวข้อง

ซอฟต์แวร์

ซอฟต์แวร์ แอปพลิเคชันบนมือถือ

แอปพลิเคชันบนมือถือ เช็คความเร็วเน็ต (Speedtest)

เช็คความเร็วเน็ต (Speedtest) เช็คไอพี (Check IP)

เช็คไอพี (Check IP) เช็คเลขพัสดุ

เช็คเลขพัสดุ สุ่มออนไลน์

สุ่มออนไลน์